Los asistentes de voz están cada vez más presentes en los hogares de todo el mundo. Si bien al principio eran algo limitados, con el paso del tiempo y las mejoras en inteligencia artificial y tecnología, se ha conseguido que estos dispositivos sirvan para algo más que para contar chistes. La única pega que existe y que todos están intentando paliar es conseguir interactuar con el asistente sin tener que decir 'Ok Google', 'Alexa', u 'Oye Siri'.

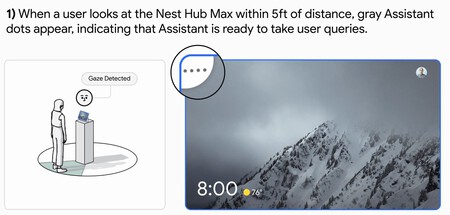

En el caso de Google, están progresando adecuadamente en ello, y en el último Google I/O anunciaron 'Look and Talk', una tecnología presente de momento únicamente en los Google Nest Hub Max y que permite activar el asistente sin decir 'Ok Google' y con tan solo mirar al dispositivo. Si bien su disponibilidad aún es limitada, desde la compañía nos han ofrecido detalles sobre cómo funciona esta tecnología.

'Look and Talk', una función para usar el asistente sin decir 'Ok Google'

A través de una entrada en el blog de Google orientado a la inteligencia artificial, nos han explicado algunos detalles más sobre cómo funciona 'Look and Talk'. Y es que para que esta tecnología funcione, depende de diversas técnicas de procesamiento de audio y vídeo, así como de los sensores del dispositivo, y ocho modelos de machine learning para garantizar que la interacción se hace de forma adecuada.

La idea con 'Look and Talk' es que puedas activar el asistente de voz de Google sin decir 'Ok Google' y con tan solo mirar a la pantalla. El Google Nest Hub Max cuenta con una cámara, con la que usa Face Match como escáner biométrico, algo que combinado con Voice Match, permite activar el asistente solamente si detecta nuestro rostro y voz.

Para hacer que la tecnología funcione con precisión, sus modelos han sido entrenados para ofrecer toda una variedad de características demográficas, como edad, tonos de piel, etc. Además, también han tenido en cuenta las situaciones adversas del mundo real, como las condiciones lumínicas menos óptimas, sombras, condiciones acústicas desfavorables, ruido de fondo, etc.

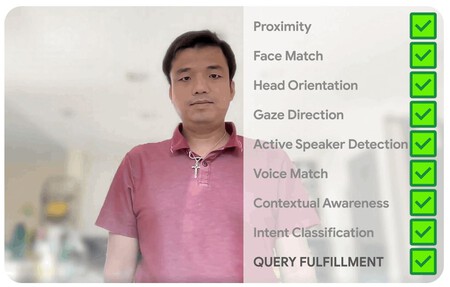

El funcionamiento de 'Look and Talk' pasa por tres fases. La primera de ellas sirve para que el asistente reconozca que el usuario tiene la intención de interactuar a través de señales visuales y activa al sistema si es el caso para escuchar la petición. Por otro lado, la segunda fase está diseñada para validar y comprender aún más la intención del usuario mediante señales visuales y acústicas. Son en estas dos fases donde la tecnología considera todas las señales para detectar correctamente si existe intención de interacción por parte del usuario, mientras que la tercera fase está únicamente destinada para el cumplimiento de la consulta.

Como explican desde Google, La función solo se activa si el modelo detecta que queremos interactuar con él. Para ello se analiza la distancia del sujeto respecto al dispositivo, la orientación de la cabeza, de la mirada, determinar si la dirección del sujeto es óptica para una conversación activa, etc.

Como método para comprobar todos esos parámetros se realiza un análisis tanto de vídeo como de audio. De esta forma, el asistente es capaz de detectar si el usuario está interactuando con el dispositivo, o con su entorno doméstico (si, por ejemplo, estamos hablando con alguien en casa, no debería activarse la detección del Asistente).

Además, también se analiza el tono de la voz, la velocidad, y demás información no léxica para saber si el usuario está intentando realizar una consulta al asistente. Para mejorar el algoritmo, Google ha desarrollado un dataset con más de 3.000 participantes a través de distintos subgrupos demográficos.

Tal y como hemos mencionado, Look and Talk todavía es una función exclusiva del Google Nest Hub Max y se encuentra únicamente disponible en inglés. Tendremos que esperar para conocer cómo avanza la tecnología y si acaba llegando a demás territorios y dispositivos.